(注:按照报告时间排序)

特邀报告1

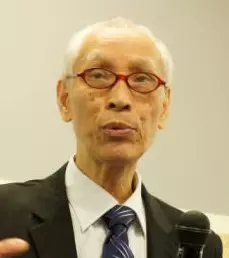

讲者:陆俭明

题目:亟需解决好中文信息处理和汉语本体研究的接口问题

时间:2020年10月31日09:00-10:00

摘要:进入21世纪,特别是近十来年,人工智能发展迅速,已经成为当今社会的“明星”。许多发达国家和发展中国家都已制定或正在制定人工智能发展计划,都把发展人工智能作为提升国家竞争力、维护国家安全的重大战略。人工智能可以分为两大类:一类跟语言无关,如电脑下围棋、象棋,汽车、飞机无人驾驶等;另一类跟语言有关,突出的如机器翻译,还有如“聊天机器人”。以汉语为处理对象的自然语言处理即“中文信息处理”,无疑为后面这一类人工智能所需要;然而当今基于人工神经网络的“机器深度学习”所获得的人工智能,与语言学本体研究,不是结合得更加紧密,而是越来越疏远了。在人工智能发展中,语言学科逐渐被边缘化,汉语语言学人面对人工智能普遍感到茫然。原因在哪里?我们不能不反思。人工智能完全靠计算机计算,算的是具有多模态的变量的目标函数“y= f(x)”。计算机凭借云计算、移动互联网所获得的大数据,以及不断优化的算法、算力,能很快求解那一个个具有多模态的变量的目标函数。显然,人工智能的快速发展就靠那“数据”“算法”“算力”三驾马车的驱动。语言学能介入人工智能的就是其中的“数据”部分。语言学介入什么?就是语言知识。语言知识怎么介入?靠中文信息处理。中文信息处理所能提供的语言知识哪儿来?需要从汉语本体研究那里来。而现在的状况是中文信息处理与汉语本体研究没连接好,换句话说,没解决好中文信息处理与汉语本体研究的接口问题。因此,说实在的,目前关涉语言的人工智能的发展,仅仅是提升了计算机的“技能”,而并非真正的“智能”;那三驾马车中的“数据”这一驾马车的驱动缺了“语言知识”这个轮子,无怪乎目前各类机器翻译问题多多。为进一步推进我国人工智能的发展,亟需解决好中文信息处理与汉语本体研究的接口问题。解决“接口”问题,中文信息处理与汉语本体研究两方面都需要作出努力。本报告仅从汉语本体研究的角度,提出一些解决好“接口”问题的意见与建议。目前我们的汉语本体研究更多地注重“理论”思辨,注重对语言现象的“解释”。这就语言研究本身而言无可非议;但从中文信息处理的应用需求角度讲,这样的汉语本体研究并不能为中文信息处理提供所需的关于语言的“知识数据”。这就要求从事汉语本体研究的学者关注、了解中文信息处理的需求,更要从中文信息处理的需求出发加强对语言事实的研究。具体说,为了能解决好中文信息处理与汉语本体研究之间的接口问题,今后汉语本体研究似需加强以下几方面的研究:第一,树立“关联”意识,运用关联理论(Relevance Theory),进一步深入句法语义研究。第二,加强词语和句法格式的句法、语义的特征研究。第三,进行汉语语言信息结构的探究。第四,加强现代汉语“边缘(periphery)结构”的研究。

简介:陆俭明,男,1935年11月生,苏州吴县人。1955年9月考入北京大学中文系学习,1960年7月毕业于北京大学中文系汉语专业并留校任教,1985年晋升为教授,1986年为国务院学位办批准为博士生导师。现任国家语委咨询委员会委员、北京语言大学汉语国际教育研究院学术委员会主任,以及武汉大学、北京师范大学、南京师范大学、北京语言大学等18所高等院校兼职教授。曾任世界汉语教学学会会长、国际中国语言学学会会长、中国语言学会副会长、北京大学汉语语言学研究中心主任、北京大学计算语言学研究所副所长、北京大学文科学术委员会委员、新加坡教育部课程发展署华文顾问等职。独立完成、出版的著作和教材共13部,主编或与他人合作编写论文集和教材12部;发表学术论文、译文、序文等400余篇,内容涉及现代汉语的本体研究和应用研究。他的《现代汉语语法研究教程》(2003;2014)已成为国内外许多高校汉语专业本科生、研究生的教材或重要参考书,并已译为韩文本;新出版的《汉语语法语义研究新探索》(2010)已为多所高校列为考研必读书。最近与马真合作撰写的《汉语教师应有的素质与基本功》一书获得学界普遍好评。2018年刚由商务印书馆出版的《新加坡华语语法》是全球第一部系统描写新加坡华语句法的语法专著。2019年又由商务印书馆出版《话说汉语走向世界》。曾主持和参与多个省部级以上的科研项目。他在学界被誉为20世纪中国现代汉语语法研究八大家之一。自1992年以来,先后获得省部级以上的奖项有10个;此外2000年荣获香港理工大学2000年度大陆杰出学人奖,2003年9月,荣获中国第一届高等学校教学名师奖,2011年荣获北京大学2011年度国华杰出学者奖,2019年12月荣获北京大学离退休教职工学术贡献特等奖。1981年以来,曾先后近50余次应邀赴美国、日本、法国、挪威、泰国、韩国、新加坡、德国、荷兰、马来西亚、澳大利亚、加拿大、葡萄牙、越南、意大利、瑞士、菲律宾以及我国港澳台等20个国家和地区任教、进行学术访问或出席国际学术会议。

特邀报告2

讲者:刘群

题目:预训练语言模型研究进展和趋势展望

时间:2020年10月31日10:00-11:00

摘要:预训练语言模型在最近的研究工作中表现出了强大的能力,为自然语言处理研究打开了全新的局面,并推动了整个人工智能领域的发展。本报告将结合华为诺亚方舟实验室在预训练语言模型方面开展的一系列工作,介绍这一领域的一些主要进展,并展望这一研究方向的发展趋势。

简介:华为诺亚方舟实验室语音语义首席科学家,负责语音和自然语言处理研究。原爱尔兰都柏林城市大学教授、爱尔兰ADAPT中心自然语言处理主题负责人、中国科学院计算技术研究所研究员、自然语言处理研究组负责人。分别在中国科学技术大学、中科院计算所、北京大学获得计算机学士、硕士和博士学位。研究方向主要是自然语言理解、语言模型、机器翻译、问答、对话等。研究成果包括汉语词语切分和词性标注系统、基于句法的统计机器翻译方法、篇章机器翻译、机器翻译评价方法等。承担或参与多项中国、爱尔兰和欧盟大型科研项目。在国际会议和期刊发表论文300余篇,被引用8000多次。培养国内外博士硕士毕业生50多人。获得过Google Research Award、ACL Best Long Paper、钱伟长中文信息处理科学技术奖一等奖、国家科技进步二等奖等奖项。

特邀报告3

讲者:张建伟

题目:跨模态学习的自适应、预测和交互

时间:2020年10月31日19:00-20:00

摘要:跨模态学习指的是对多种感官信息的综合,通过利用一种或多种来自于其它感官的信息来提高某一单独感官的学习效果。人脑的跨模态学习表现为以下两种形式:(1)对于一种感知的输入,如果存在来自其他模态的一致的信息,那么该模态就会被更快更强地激活;(2)如果一种或多种模态的感知功能减弱或丧失,某种其他模态的刺激可能会增强。跨模态学习是人理解动态世界的过程中不可或缺的一步,比如:学习抓取和操作物体,学习行走,学习读和写,学习语言及其所指的物体等等,视觉、听觉、躯体感觉或者其它感知方式必须要综合起来进行分析,进行自适应的变化、交互和预测。对于神经网络模型和神经机器人,如果可以构建基于多传感器的多模态系统,跨模态学习将能在总体上增强系统的能力,体现在更强的鲁棒性、更快的适应性和更可靠的预测性。报告将分析目前人工智能在机器人领域的发展现状,通过“2.0机器人与2.0人类”的项目深入介绍大脑启发式深度学习、多模态数据处理、图像信息的语言理解、人机协作中的跨模式感知和学习等关键技术。

简历:德国汉堡大学信息学科学系教授,多模态技术研究所所长,德国汉堡科学院院士。1986年清华大学计算机系学士毕业,1989年清华大学计算机系硕士毕业,1994年德国卡尔斯鲁厄大学计算机系博士毕业,主攻机器人方向。在德国从事及领导智能感知、机器学习、自主规划、多传感信息融合、智能机器人、多模态人机交互等领域的研究与开发。发表三百余篇论文专著,多次获得国际会议最佳论文奖,拥有四十余项发明专利。担任多个国际智能机器人及智能控制会议的大会主席、数家国际企业顾问、国务院侨办及中国侨联专家海外咨询委员、德国清华校友会会长、德中企业家联合会会长、北德华人华侨联合会会长。

特邀报告4

讲者:Mirella Lapata

题目:What's This Movie About? Automatic Content Analysis and Summarization

时间:2020年10月31日20:00-21:00

摘要:Movie analysis is an umbrella term for many tasks aiming to automatically interpret, extract, and summarize the content of a movie. Potential applications include generating shorter versions of scripts to help with the decision making process in a production company, enhancing movie recommendation engines, and notably generating movie previews. In this talk I will introduce the task of turning point identification as a means of analyzing movie content. According to screenwriting theory, turning points (e.g., change of plans, major setback, climax) are crucial narrative moments within a movie: they define its plot structure, determine its progression and segment it into thematic units. I will argue that turning points and the segmentation they provide can facilitate the analysis of long, complex narratives, such as screenplays. I will further formalize the generation of a shorter version of a movie as the problem of identifying scenes with turning points and present a graph neural network model for this task based on linguistic and audiovisual information. Finally, I will discuss why the representation of screenplays as (sparse) graphs offers interpretability and exposes the morphology of different movie genres.

简介:Mirella Lapata is professor of natural language processing in the School of Informatics at the University of Edinburgh. Her research focuses on getting computers to understand, reason with, and generate natural language. She is the first recipient (2009) of the BCS and Information Retrieval Specialist Group (BCS/IRSG) Karen Sparck ones award and a Fellow of the Royal Society of Edinburgh. She has also received best paper awards in leading NLP conferences and has served on the editorial boards of the Journal of Artificial Intelligence Research, the Transactions of the ACL, and Computational Linguistics. She was president of SIGDAT (the group that organises EMNLP) in 2018.

特邀报告5

讲者:施路平

题目:面向人工通用智能的类脑计算

时间:2020年11月1日09:00-10:00

摘要: 类脑计算是借鉴人脑存储处理信息的方式发展的新型计算技术,类脑计算系统是面向人工通用智能基于神经形态工程打破“冯•诺依曼”架构束缚、适于实时处理非结构化信息、具有学习能力的超低功耗新型计算系统。当前欧盟、美国等均斥巨资长期支持此研究,但是这项研究目前处于起步阶段,尚未形成公认技术方案。此报告将从为什么(why)?做什么(what)?和怎样做(how)?三方面来分析类脑计算、芯片及系统面临的挑战和可能的解决方法,介绍本领域最新进展,重点讨论如何将脑科学和计算机融合,促进人工通用智能的研究。

简历:清华大学教授,清华大学类脑计算研究中心主任,光盘国家工程研究中心主任,国际光学工程学会(SPIE)会士。1992年从德国科隆大学获博士学位, 1996-2013在新加坡科学院数据存储研究院光学材料和系统实验室主任, 非易失性存储器实验室主任。2013年加入清华大学创建类脑计算研究中心,中心从基础理论、类脑芯片、类脑软件、系统和应用对类脑计算进行全面研究。提出异构融合类脑计算架构,研制了全球首款异构融合类脑计算“天机芯”,利用一款天机芯构建了人工通用智能研究演示平台-自动行驶自行车,相关结果作为封面文章于2019.08.01发表在Nature上,被两院院士评为2019年中国十大科技进展。研究领域:类脑计算、信息存储、集成光电子、智能仪器。已发表近200多篇学术论文 (包括Science,Nature,Nature Photonics), 2004年以第一完成人荣获新加坡国家科技奖(当年唯一)。

特邀报告6

讲者:刘铁岩

题目:四两拨千斤:实现高效的NLP模型预训练

时间:2020年11月1日10:00-11:00

摘要: 近年来, 在深度学习技术的加持下,自然语言处理(NLP)取得了突飞猛进的发展,在机器翻译、阅读理解等领域都在特定场景下接近甚至超越了人类的水准。然而,在此过程中, “大力出奇迹”的训练手段大行其道,人们在训练数据量、模型容量、算力上不断加码。比如,对于语言模型预训练而言,就从一亿参数的BERT模型一路增长至上千亿参数的GPT-3模型,所需的计算资源也从几十块GPU飙升至上万块GPU,单次训练的成本竟高达上千万美元。这类工作虽然从某种意义上探索着技术的边界,但也导致明显的马太效应,使得没有足够算力的研究者和学术机构逐渐失去话语权。为了打破这种不良局面,我们针对NLP模型训练的效率问题进行了深入的研究,从数据处理、模型结构、损失函数、优化算法等多个维度进行了探索,将训练效率提高了一个数量级;未来我们将致力于更大幅度的提速,从而助力NLP技术的平民化、为更加多样的技术创新奠定基础。

简历:刘铁岩博士,微软亚洲研究院副院长,IEEE会士, ACM杰出科学家。他也是CMU、清华大学、中国科技大学的兼职教授。刘博士的先锋性研究促进了机器学习与信息检索之间的融合,被公认为“排序学习”领域的代表人物。近年来他在深度学习、强化学习等方面也颇有建树,在顶级国际会议和期刊上发表论文两百余篇,被引用数万次。他担任了WWW、ACL、SIGIR、KDD、NeurIPS、ICLR、AAAI、IJCAI等顶级会议的大会主席、程序委员会主席或领域主席;ACM TOIS、ACM TWEB、IEEE TPAMI等知名国际期刊副主编。他曾获得多项最佳论文和最高引论文奖、CCF青竹奖、中国AI英雄风云榜技术创新人物奖、AMiner全球最具影响力学者奖、CSDN技术领航者奖、机器之心最佳AI应用案例等奖项。他的团队开源了LightGBM,已成为Kaggle比赛和KDD Cup中最受欢迎的机器学习工具;帮助微软在中英新闻翻译任务上达到了人类专家水平,并获得WMT2019机器翻译比赛8项冠军;研发了史上最强麻将AI Suphx,在知名麻将平台“天凤”上荣升十段,稳定段位显著超越人类顶级选手。近年来他还与多个行业进行了战略研究合作(如华夏基金、东方海外、中国太平、顺丰、远传电信等)成功助力合作伙伴实现智能化转型。

特邀报告7

讲者:Iryna Gurevych

题目:Let’s Argue: Understanding and Generating Arguments

时间:2020年11月1日11:00-12:00

摘要: People love to argue. In recent years, Artificial Intelligence has achieved great advances in modelling natural language argumentation. While analysing and creating arguments is a highly complex (and enjoyable!) task at which even humans are not good, let alone perfect, we describe our natural language processing (NLP) research to identify arguments, their stance and aspects, aggregate arguments into topically coherent clusters, and finally, even to generate new arguments, given their desired topic, aspect and stance. The talk will tell you the story how the ArgumenText project has been conceptualized into a set of novel NLP tasks and highlight their main research outcomes. Argument mining has a tremendous number of possible applications, of which the talk discusses a few selected ones.

简历:Iryna Gurevych (PhD 2003, U. Duisburg-Essen, Germany) is a professor of Computer Science and director of the Ubiquitous Knowledge Processing (UKP) Lab at the Technical University (TU) of Darmstadt in Germany. She joined TU Darmstadt in 2005 (tenured as full professor in 2009). Her main research interest is machine learning for large-scale language understanding, including text analysis for social sciences and humanities. She is one of the co-founders of the field of computational argumentation with many applications, such as the identification of fake news and decision-making support. Iryna’s work received numerous awards, e.g. a highly competitive Lichtenberg-Professorship Award from the Volkswagen Foundation and a DFG Emmy-Noether Young Researcher’s Excellence Career Award. Iryna was elected to be President of SIGDAT, one of the most important scientific bodies in the ACL community. She was program co-chair of ACL’s most important conference in 2018, the Annual Meeting of the Association for Computational Linguistics, and she is General Chair of *SEM 2020, the 9th Joint Conference on Lexical and Computational Semantics.